马斯克xAI每月免费150刀额度别浪费,grok3模型接入VsCode

发布时间: 2025-01-24

前言

年初的时候,马斯克的xAI搞了一个活动,给每个充值5刀的账号,每月发放150刀的免费额度,你需要共享你的数据给xAi训练模型(也就是你的提问会被留存), 领取说简单也简单,说难也难,简单的时网上很多人在分享这个事情,注册、用一张visa的信用卡充值5美刀进去就完事儿了,复杂的是xAI今年把很多地方 的访问都屏蔽了,留学生才能访问,而且有些云厂商的海外服务器也被屏蔽了,无法打开xAI的官网。

说来也巧,最近经常用豆包mac版,也会用豆包在vscode中开发的插件 Mars ,也用了他们家的编辑器 Trae。

一开始我用Trae,逐渐发现编辑器支持度没有Vscode好,而且构建模式是又慢又不怎么可靠,于是放弃,改用豆包,复制过来复制过去也麻烦,然后又用Mars的 doubao-1.5-pro 模型,

回复速度实在是抠脚,近期因为我不会rust,需要让它给我把js代码转换成rust代码,搞了无数次还是无法运行,整了几个小时候,我放弃了,直接去用grok-3,生成的代码一次通过,

于是我就有了把grok-3集成到vscode中来代替mars的想法。

先要能访问到xai的api

首先测试一下你能联通xai否

curl https://api.x.ai/v1/chat/completions \

-H "Content-Type: application/json" \

-H "Authorization: Bearer 你的token" \

-d '{

"messages": [

{

"role": "system",

"content": "你是一个通用机器人"

},

{

"role": "user",

"content": "你好,你是哪个公司"

}

],

"model": "grok-3",

"stream": false,

"temperature": 0

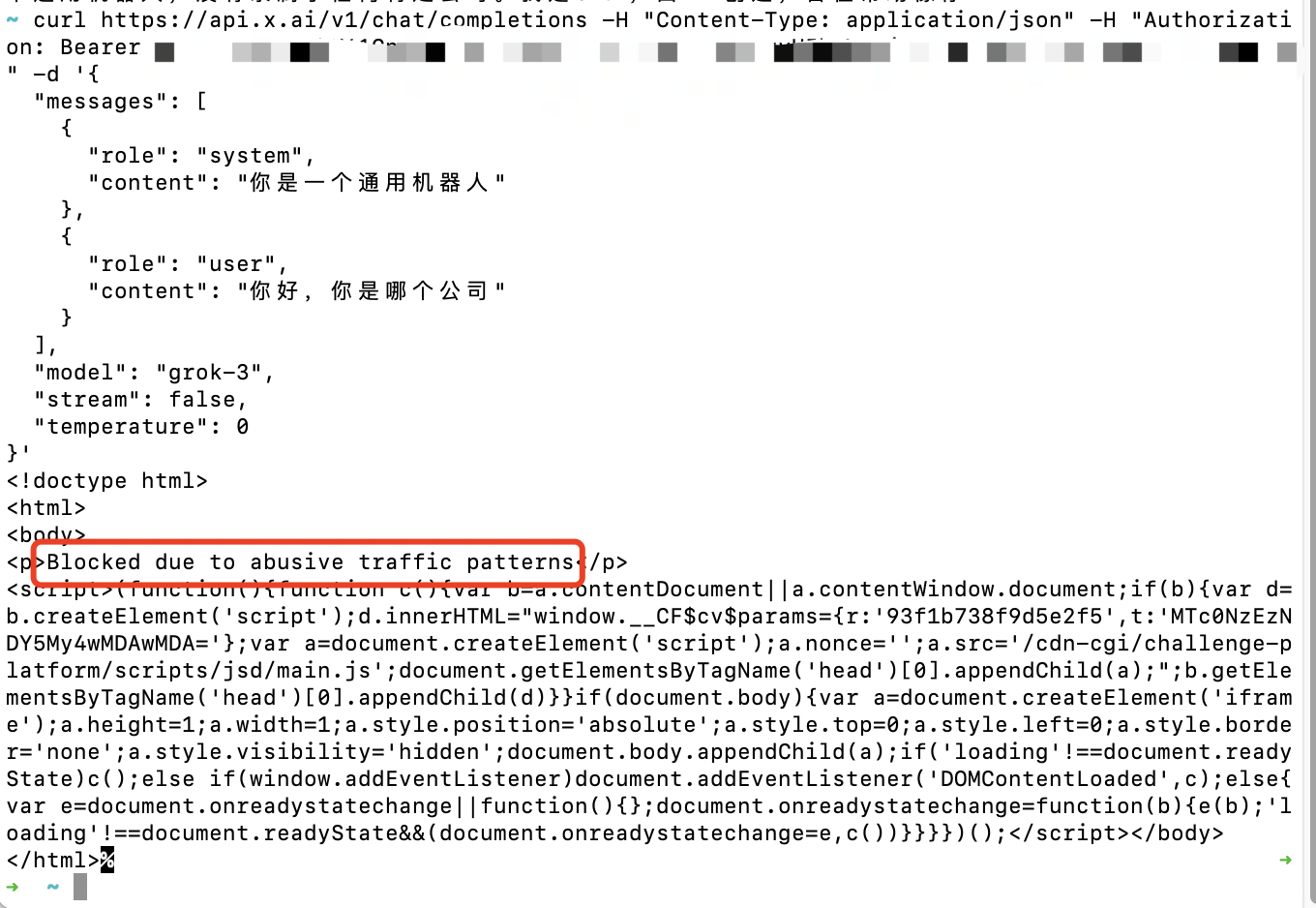

}'如果能返回回答,则说明你所在位置是可以联通的,国内基本不用想,肯定不能联通,所以要使用vercel代理。 你大概率会得到这样一个返回:

这是马斯克主动决绝向你所在地区提供服务.

vervel部分的操作不便讲解,可以使用这个这个项目一键部署,链接 方法都写到readme了,记得一定要仔细阅读,跟着做,有问题可以直接在里面提issue

grok-3模型接入VsCode

测试你的域名访问xai的连通性

和上面差不多,改改你的域名

curl https://你的域名/v1/chat/completions \

-H "Content-Type: application/json" \

-H "Authorization: Bearer 你的token" \

-d '{

"messages": [

{

"role": "system",

"content": "你是一个通用机器人"

},

{

"role": "user",

"content": "你好,你是哪个公司"

}

],

"model": "grok-3",

"stream": false,

"temperature": 0

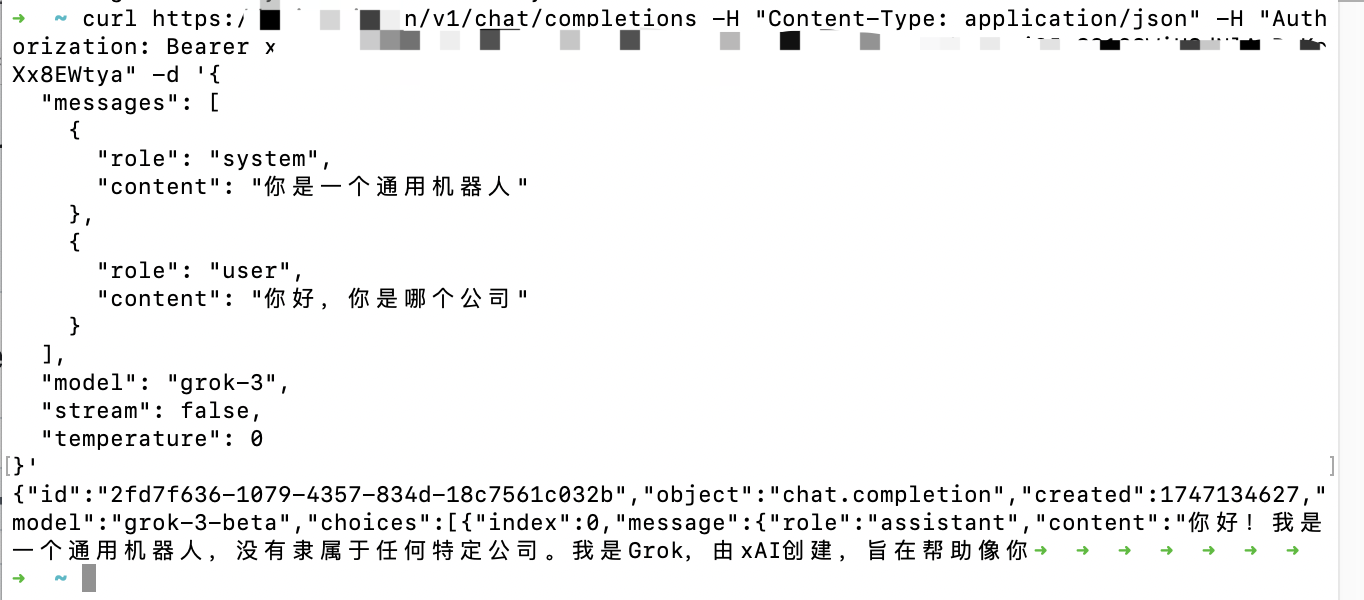

}'现在你可以得到这样的答复

安装插件

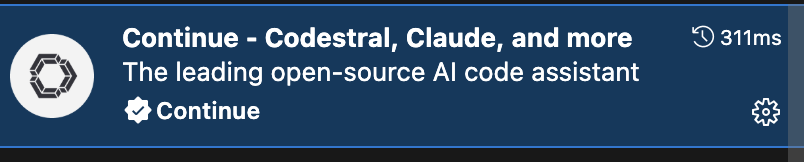

在vscode中安装 continue 插件,地址 ,也可以在vscode扩展中搜索“continue”,

找到这个就对了

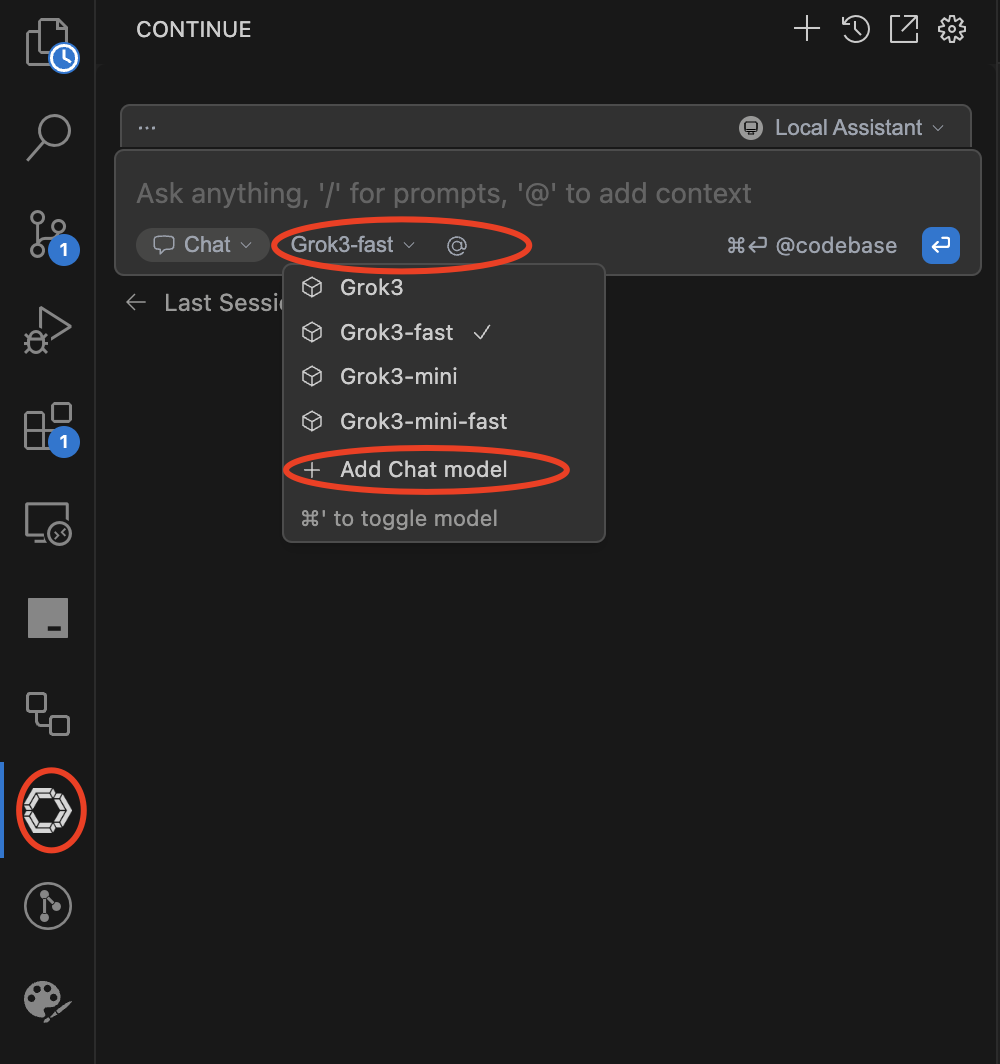

安装后,在左侧有一个圈圈图标,点击后选 local assistant

然后在这里添加模型,我是已经配置好了4个最新的模型了,你需要点 Add Chat model 去添加。

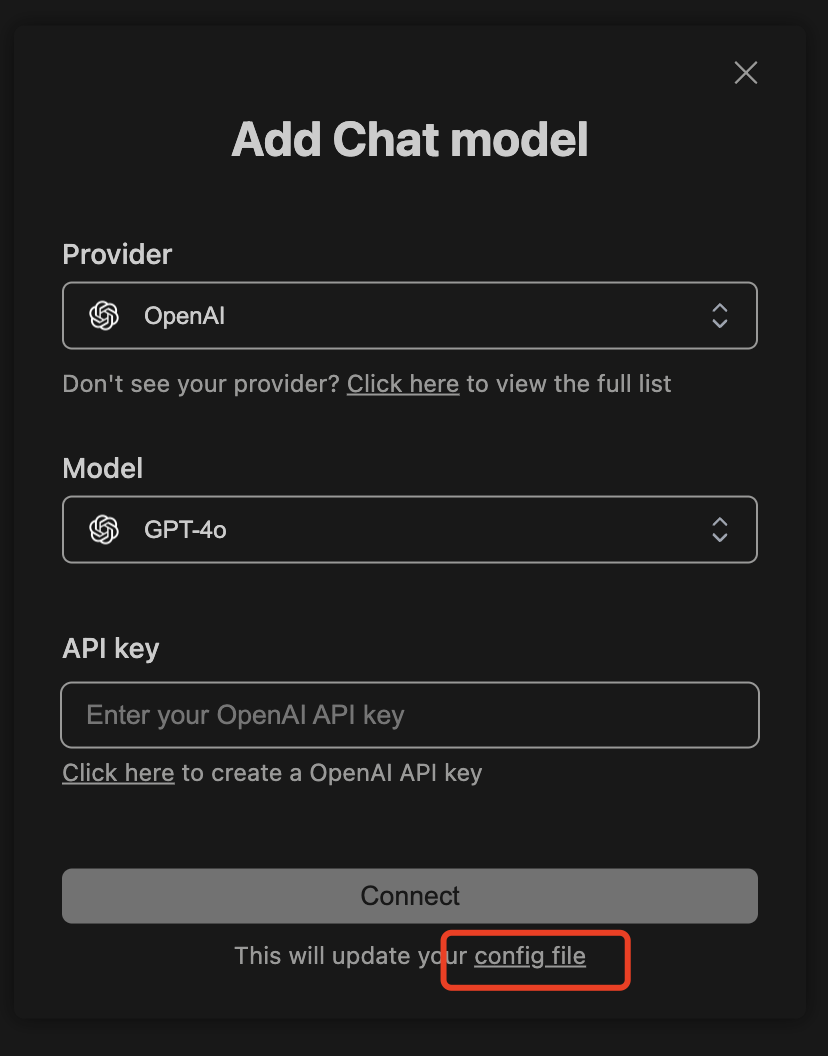

点击后可以看到这样一个框, 点击config file打开配置文件,我们手动配置

打开后我们配置上我们要使用的grok模型

name: Local Assistant

version: 1.0.0

schema: v1

models:

- name: Grok3

provider: xAI

model: grok-3-latest

apiKey: 你的token

apiBase: https://你的域名/v1

roles:

- chat

- edit

- apply

- name: Grok3-fast

provider: xAI

model: grok-3-fast

apiKey: 你的token

apiBase: https://你的域名/v1

roles:

- chat

- edit

- apply

- name: Grok3-mini

provider: xAI

model: grok-3-mini

apiKey: 你的token

apiBase: https://你的域名/v1

roles:

- chat

- edit

- apply

- name: Grok3-mini-fast

provider: xAI

model: grok-3-mini-fast

apiKey: 你的token

apiBase: https://你的域名/v1

roles:

- chat

- edit

- apply

context:

- provider: code

- provider: docs

- provider: diff

- provider: terminal

- provider: problems

- provider: folder

- provider: codebase全部配置完成,建议使用vercel的朋友使用grok-3-fast模型,因为vercel普通用户限制每次请求最长60秒,超时会掐断,所以我们尽可能使用快速的模型,虽然贵一点, 每个月150刀也是够用的。

现在还有问题,选择的文件过大会报错超出模型支持的长度,应该是要查看一下怎么配置文件分片之类的配置。

continue的其他配置

查看 https://docs.continue.dev/reference#models 和 https://docs.continue.dev/json-reference#models